فایل Robots.txt چیست؟ + آموزش کامل ساخت آن

فایل Robots.txt یک فایل متنی است که وبمسترها برای مدیریت ربات های وب (که اغلب ربات های موتور جستجو هستند) از آن استفاده می کنند. این فایل مشخص می کند که چگونه ربات ها، صفحات وبسایت شما بررسی کنند. فایل Robots.txt بخشی از پروتکل حذف ربات ها (REP) است.

این پروتکل به دسته ای از استانداردهای وب اطلاق می شود که مدیریت ربات ها را برای خزش در وب (Web Crawling)، دسترسی و ایندکس محتوا و قرار دادن محتوا در اختیار کاربران، بر عهده دارد. REP همچنین شامل دستورهایی نظیر متا ربات ها، دستورالعمل های پیج، دایرکتوری های فرعی و site-wide می شود که مربوط به چگونگی رفتار موتورهای جستجو با لینک ها است. (مثلاً چگونگی follow و یا unfollow کردن لینک ها)

در اصل، فایل های Robots.txt مجموعه ای از دستورالعمل های مربوط به ربات ها را در بر دارد. این فایل به صورت پیش فرض در فایل های سورس بیشتر وبسایت ها موجود است. فایل های Robots.txt بیشتر برای مدیریت فعالیت های ربات ها استفاده می شوند.

مدیریت ربات های خزنده به معنی دستور دادن به آنها برای بازدید از یک صفحه و محتوای خاص و یا عدم بازدید از یک صفحه از وبسایت شما است. لزوم این مدیریت، این است که برخی از ربات ها از دستورالعمل های تعیین شده پیروی نمی کنند.

فایل Robots.txt چیست؟

فایل Robots.txt یک تابلوی «آیین نامه رفتاری» برای ربات هاست که در یک مکان عمومی نصب شده است. این تابلو به تنهایی توانایی اجرای مقررات و دستور العمل ها را ندارد، اما شهروندان متعهد، با دیدن این تابلو، از قوانین آن پیروی می کنند، در حالی که شهروندان غیرمتعهد، این قوانین را تقض کرده و به آن تعهدی ندارند (مثال).

ربات در واقع یک برنامه کامپیوتری خودکار است که با اپلیکیشن ها و وبسایت ها در تقابل است. ربات ها هم خوب هستند و هم بد، یک نمونه از ربات های خوب، ربات های خزنده وب نام دارند. این ربات ها بین صفحات وب می خزند (بررسی می کنند) و محتوای صفحات را ایندکس می کنند، به گونه ای که محتوای سایت در نتایج موتورهای جستجو قابل نمایش خواهد بود. فایل Robots.txt به مدیریت فعالیت این خزنده های وب کمک می کند؛ تا اضافه بار سرور وب را که توسط ربات ها ایجاد شده است، کم کرده و از بروز مشکل برای سرور جلوگیری نمایند.

دلایل استفاده از Robots.txt و اهمیت آن

پیش از توضیح در مورد اهمیت فایل Robots.txt، لازم است انواع آن را بشناسیم. فایل Robots.txt که با نام پروتکل استاندارد حذف ربات ها نیز شناخته می شود، نمونه های مختلفی دارد که در ادامه برخی از آن ها را معرفی خواهیم کرد.

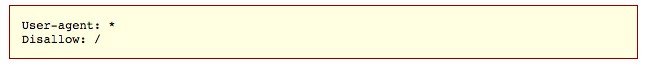

فرض کنید موتور جستجو، فایل Robots.txt زیر را پیدا می کند:

این فایل، ساختار اصلی یک Robots.txt را نشان می دهد. علامت * بعد از «user-agent» به این معنی است که دستورالعمل های موجود در فایل Robots.txt برای همه ربات های وب که از سایت شما بازدید می کنند، اعمال می شود. علامت / پس از «Disallow» به ربات ها می گوید که از هیچ صفحه ای در وبسایت شما بازدید نکنند.

شاید برایتان سؤال پیش بیاید که چرا باید ربات ها مایل باشند از بازدید یک صفحه در وبسایت، منع شوند؟ به هر حال، یکی از اهداف اصلی سئو این است که موتورهای جستجو بتوانند صفحات وبسایت شما را راحت تر جستجو کرده تا رتبه سایت شما را بهبود بخشند. اما این دقیقاً همان جایی است که ترفند سئو برای آن مطرح می شود.

یعنی به دلیل وجود صفحات زیاد در وبسایت شما، وقتی موتور جستجو، وبسایت شما را جستجو می کند، بین هر صفحه از وبسایت می خزد و اگر تعداد صفحات زیاد باشد، انجام این کار بسیار زمان بر بوده و ربات ها زمان زیادی را برای خزندگی بین صفحات وبسایت شما صرف می کنند. این مسئله می تواند روی رتبه وبسایت شما در موتور جستجو، تأثیر منفی بگذارد.

برای ربات ها (ربات های جستجوی گوگل)، معیاری به نام «بودجه خزش» یا crawl budget تعریف می شود که مقدار محدودی است. این معیار، به معنی تعداد صفحاتی است که ربات گوگل در یک بازه زمانی مشخص، بازدید و ایندکس می کند.

این بودجه خزش از دو فاکتور تشکیل شده است: فاکتور تقاضای خزیدن یا Crawl Demand و فاکتور محدودیت نرخ خزش یا Crawl rate limit. فاکتور تقاضای خزیدن، مشخص کننده تعداد صفحاتی است که در طول یک بار خزیدن، باید بازدید شوند. تقاضای خزیدن بر اساس جدول زمان بندی صورت می گیرد که اولویت صفحاتی را که باید بازدید شوند، مشخص می کند. فاکتور دوم، محدودیت نرخ خزش است و همانطور که از نامش پیداست، برای بازدید گوگل از صفحات یک وبسایت، محدودیت در نظر می گیرد. به این دلیل که جستجوی نامحدود صفحات، سبب کند شدن سرعت وبسایت، افزایش فشار روی سرور و در نهایت از دسترس خارج شدن آن می شود.

به زبان ساده تر، بودجه خزش، تعداد آدرس های URL است که ربات گوگل می تواند بازدید کند. بنابراین شما باید به ربات گوگل کمک کنید تا زمان را مدیریت کرده و تنها صفحات مهم شما را جستجو کند. با ساخت یک فایل Robots.txt درست، می توانید برای ربات گوگل مشخص کنید که از بازدید و ایندکس برخی از صفحات خاص در وبسایت شما، اجتناب کند. در این صورت، تنها محتوای صفحات مهم در وبسایت شما ایندکس خواهند شد. همچنین بودجه خزش نیز به صورت بهینه مصرف می شود. مزایای استفاده از فایل Robots.txt را می توان به صورت زیر بیان کرد :

- جلوگیری از نمایش محتوای تکراری در SERP ها (صفحات نتایج موتور جستجو)

- حفظ حریم خصوصی کل بخش های یک وبسایت

- جلوگیری از نمایش صفحات نتایج جستجوی داخلی روی یک SERP عمومی

- تعیین محل نقشه سایت

- جلوگیری از ایندکس شدن فایل های وبسایت شما در صورت لزوم توسط موتورهای جستجو (مثلا عکس ها، فایل های PDF و غیره).

- تعیین تأخیر در خزیدن ربات های خزنده به منظور جلوگیری از اضافه بار سرورها هنگامی که خزنده ها به صورت همزمان، چندین محتوا را بازدید می کنند.

فایل Robots.txt چگونه کار می کند؟

فایل Robots.txt تنها یک فایل متنی بدون کد نشانه گذاری HTML است (به همین خاطر پسوند .txt دارد). این فایل درست همانند سایر فایل های وبسایت، روی وب سرور میزبان است. در واقع، می توان فایل Robots.txt را برای هر وبسایت دلخواه، با تایپ آدرس URL صفحه اصلی سایت به صورت کامل و افزودن /robots.txt در ادامه آن، در مرورگر، مشاهده کرد. به عنوان مثال، فایل Robots.txt برای وبسایت کلادفلر با تایپ آدرس https://www.cloudflare.com/robots.txt در مرورگر نمایش داده می شود.

این فایل به سایر بخش های سایت لینک نشده است، بنابراین کاربران به ندرت آن را مشاهده می کنند، اما اکتر ربات های خزنده وب قبل از خزیدن در میان صفحات وبسایت شما، ابتدا به جستجوی این فایل می پردازند.

فایل Robots.txt دستورالعمل هایی را برای ربات های خزنده ارائه می دهد، اما خود نمی تواند آنها را اجرا کند. یک ربات خوب، مانند ربات خزنده وب، و یا ربات خبرخوان، سعی می کند قبل از بازدید از صفحات وبسایت در یک دامنه خاص، فایل Robots.txt را بیابد و دستورالعمل های آن را دنبال کند. در نقطه مقابل، عملکرد ربات های بد به گونه ای است که یا دستورالعمل های فایل Robots.txt را نادیده می گیرند و یا صفحات ممنوعه ذکر شده در این فایل را پردازش می کنند.

ربات خزنده وب، دستورات ویژه ارائه شده در فایل Robots.txt را دنبال می کند. اگر دستورات با هم در تناقض بودند، ربات دستورات دقیق تر را دنبال می کند. نکته مهم این است که همه زیردامنه ها، به فایل Robots.txt اختصاصی خود نیاز دارند. برای مثال، وبسایت www.cloudflare.com فایل Robots.txt اختصاصی خود را دارد. همچین زیردامنه های Cloudflare (مثلاً blog.cloudflare.com، community.cloudflare.com و غیره) نیز هر یک دارای فایل Robots.txt اختصاصی خود هستند.

فرمت اصلی فایل Robots.txt به صورت زیر است:

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

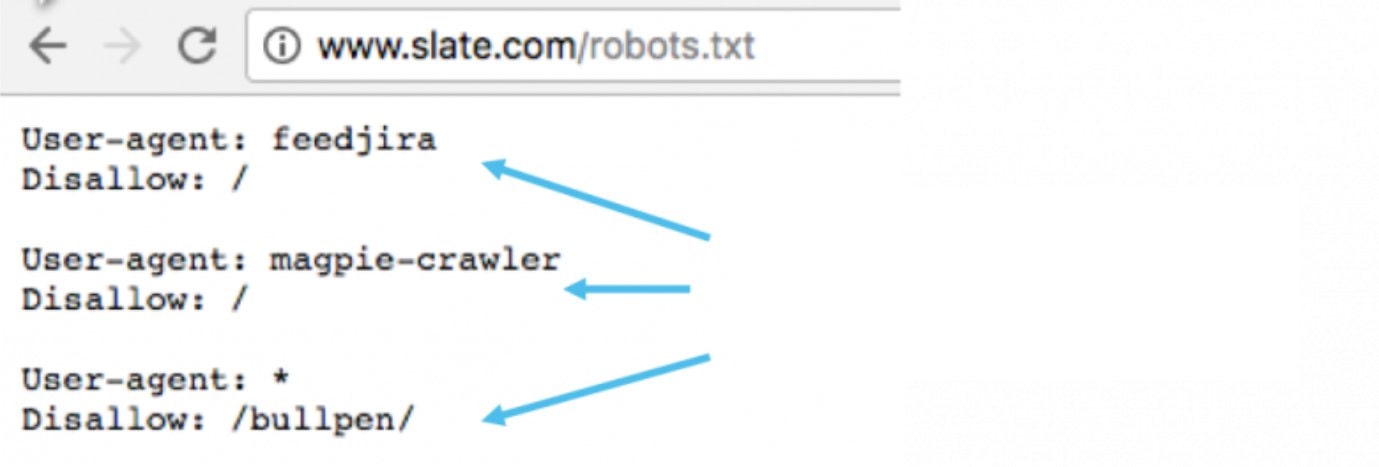

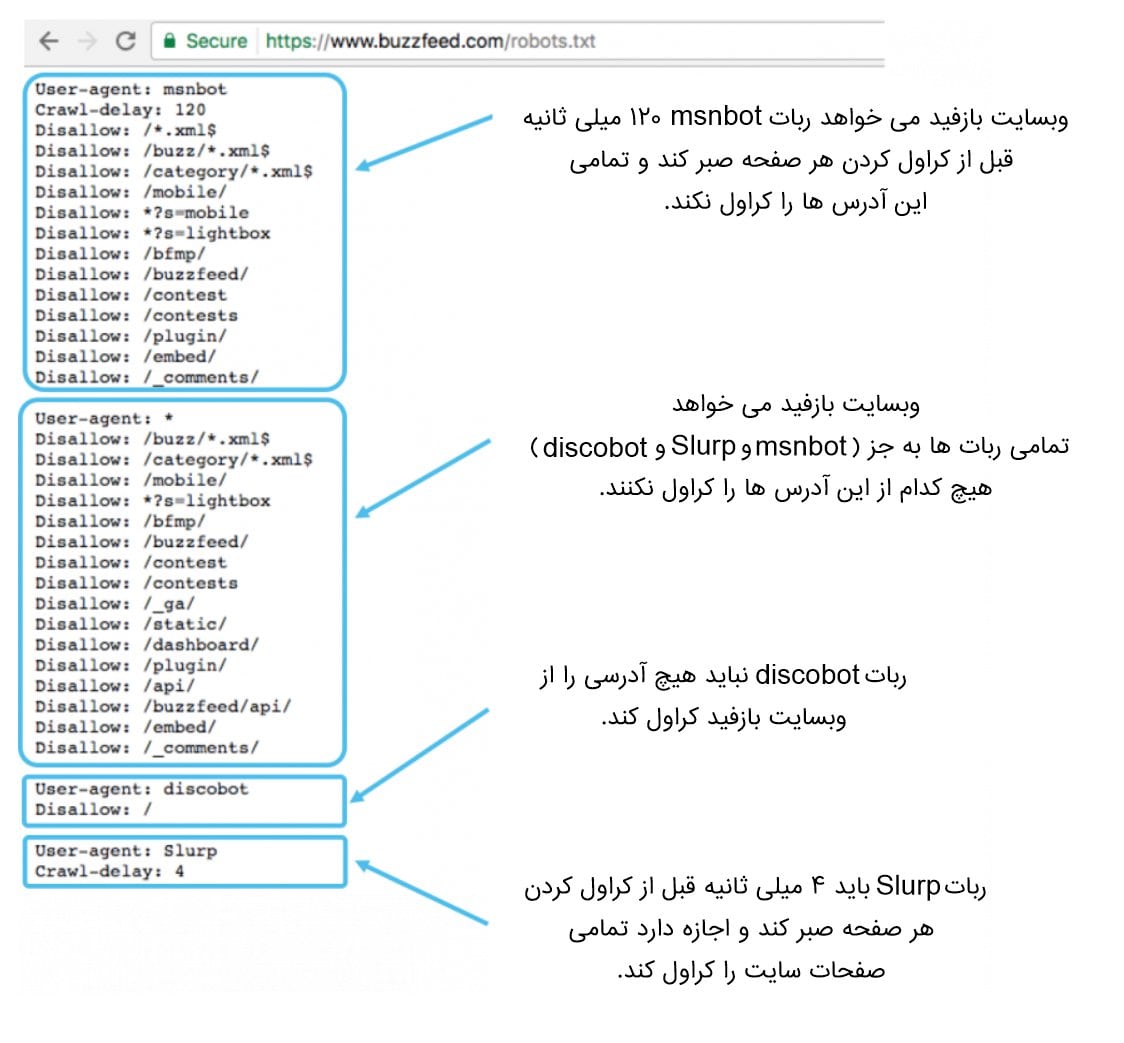

یک فایل Robots.txt ممکن است چندین کاراکتر User-agent و یا Disallow داشته باشد، مانند نمونه زیر:

اما نکته مهم این است که هر ترکیب User-agent و یا Disallow به صورت جداگانه نمایش داده شده و با یک خط از هم جدا می شوند. این بدان معنی است که هر دستورالعمل Disallow یا Allow در هر ترکیب، تنها برای User-agent خود که در خط بالا نوشته شده است، اعمال می گردد.

گاهی نیز ممکن است دستورالعمل های متعددی برای یک User-agent تعریف شده باشد که در این صورت، دستورات به ترتیب اولویت، زیر هم نوشته می شوند. یا اگر بخواهیم مجموعه دستورالعمل هایی را برای همه User-agent ها اعمال کنیم، در خط اول، پس از User-agent، علامت * قرار می دهیم. نمونه هایی از این ترکیب ها، در عکس زیر نشان داده شده است.

چطور یک فایل Robots.txt بسازیم؟

برای ساخت یک فایل Robots.txt، می توان از ویرایشگر متن استفاده کرد. ویرایشگر متن ساده Notepad را می توان برای این کار استفاده کرد. به یاد داشته باشید که اگر Robots.txt از قبل وجود داشته باشد، می بایست متن داخل آن را پاک کنید (اما خود فایل را حذف نکنید). در مجموع، پنج عبارت دستوری رایج وجود دارد که در فایل های Robots.txt مورد استفاده قرار می گیرند:

- User-agent : یک خزنده وب مشخص را تعیین می کند تا دستورالعمل های خزندگی تعیین شده را دنبال کند (معمولاً یک موتور جستجو است مانند Googlebot، LinkWalker، Robozilla و غیره).

- Disallow : این دستور به User-agent می گوید که یک URL خاص را بازدید نکند. برای هر آدرس URL، تنها یک دستور Disallow استفاده می شود.

- Allow (فقط برای موتور جستجوی Googlebot کاربرد دارد) : به Googlebot می گوید که می تواند به یک صفحه خاص یا زیرپوشه مشخص دسترسی داشته باشد، حتی اگر صفحات بالاتر و یا پوشه های اصلی، با دستور Disallow مشخص شده باشند.

- Crawl-delay : تعیین می کند که خزنده، می بایست چند ثانیه پیش از بازدید از محتوای یک صفحه، صبر کند. توجه داشته باشید که این دستور برای Googlebot شناخته شده نیست؛ به جای آن می توان نرخ خزش یا crawl rate را برای ربات گوگل مشخص کرد.

- Sitemap : برای تعیین مکان نقشه سایت (یا نقشه های سایت) XML مرتبط با یک URL استفاده می شود. این دستور تنها توسط موتورهای جستجوی Google, Ask, Bing و Yahoo پشتیبانی می شود)

هنگام نوشتن دستورات در فایل Robots.txt، کاراکتر هایی نظیرعلامت * و /، $ استفاده می شود که هر یک معنی خاص خود را دارد:

- علامت * بعد از User-agent: به معنی اعمال دستورالعمل ها برای همه User-agentها است.

- علامت / بعد از Disallow: به معنی اجتناب User-agent از بازدید URL مقابل آن است.

- علامت $ در انتهای آدرس URL، برای مطابقت با انتهای آدرس URL استفاده می شود.

برای افزودن فایل Robots.txt به سایت خود، ادامه مقاله را دنبال کنید.

نحوه تست Robots.txt

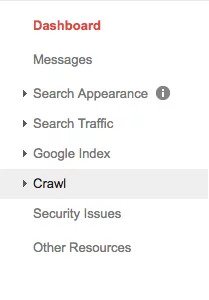

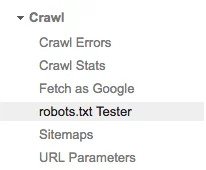

برای اضافه کردن و تست فایل Robots.txt، ابزاری تحت عنوان robots.txt Tester توسط گوگل ارائه شده است. برای استفاده از این ابزار، به حساب کاربری وبمستر خود وارد شوید و لاگین کنید (یا روی لینک https://www.google.com/webmasters/tools/robots-testing-tool کلیک کنید). در قسمت داشبورد، روش گزینه Crawling کلیک کنید.

در منوی درختی Crawling، گزینه robots.txt Tester را کلیک کنید.

باکسی به شکل زیر باز می شود:

در صورتی که قبلاً فایل Robots.txt داشته باشید، می توانید محتوای آن را پاک کرده و محتوای فایل جدید Robots.txt را درج کنید و روی گزینه Submit کلیک نمایید. سپس در قسمت پایین باکس، آدرس URL سایت را وارد کرده و User-agent را انتخاب کنید (در حالت پیش فرض Googlebot است). با کلیک روی گزینه Test، فایل شما تست شده و در صورتی که Allowed نمایش داده شود، یعنی فایل جدید معتبر خواهد بود.

فایل Robots.txt در وردپرس

سایت وردپرس نیز همانند سایر سایت ها، به فایل Robots.txt نیاز دارد. برای ایجاد و ویرایش فایل Robots.txt در سایت وردپرس، افزونه های متعددی نظیر Yoast SEO، One SEO در نظر گرفته شده است. در این بخش، نحوه ایجاد و ویرایش فایل Robots.txt را به کمک این دو افزونه وردپرس، بیان خواهیم کرد.

ایجاد و ویرایش فایل Robots.txt با Yoast SEO

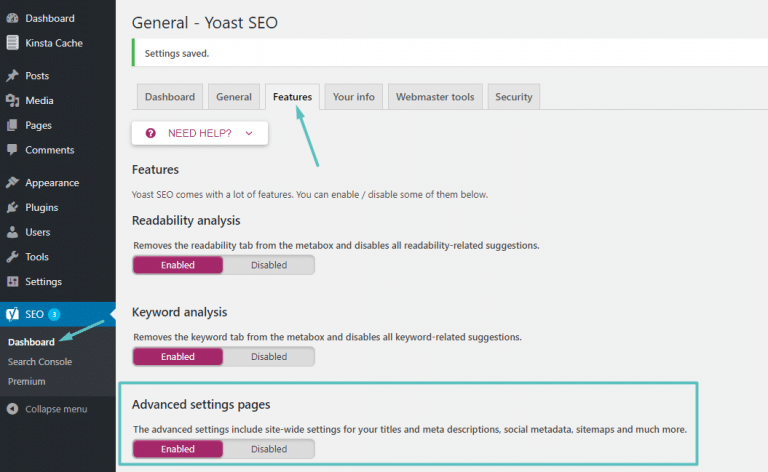

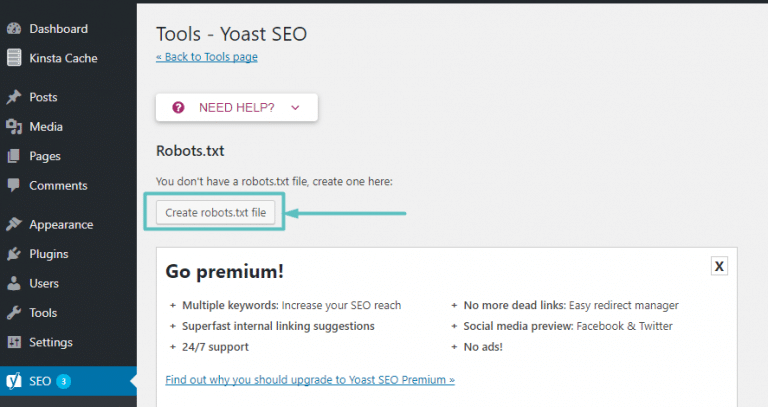

اگر از افزونه Yoast SEO استفاده می کنید، می توانید فایل Robots.txt را به کمک آن ایجاد و سپس ویرایش کنید. پیش از این کار، می بایست این قابلیت را در افزونه Yoast SEO فعال کنید. برای این منظور، ویژگی های پیشرفته Yoast SEO را با مراجعه به مسیر SEO → Dashboard → Features و فعال سازی قسمت Advanced settings pages (با کلیک کردن روی گزینه Enabled)، فعال کنید.

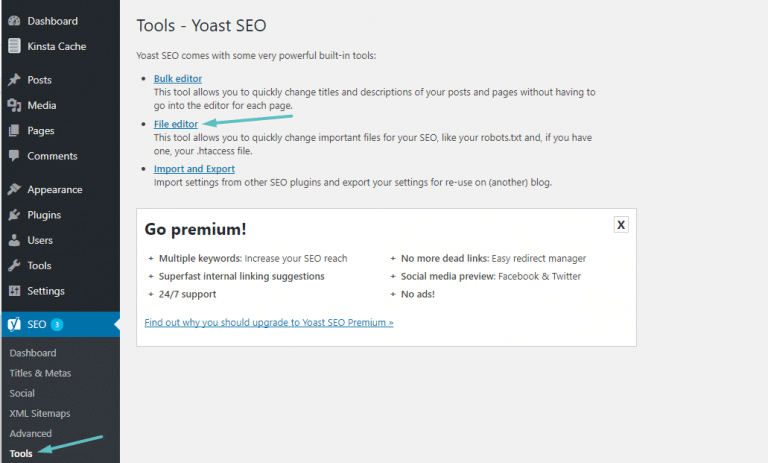

پس از فعال سازی این بخش، به مسیر SEO → Tools رفته و روی گزینه File editor کلیک کنید.

در صورتی که قبلاً فایل Robots.txt ایجاد نکرده اید، افزونه Yoast به شما امکان ایجاد فایل را خواهد داد. برای این منظور روی گزینه Create robots.txt file کلیک کنید.

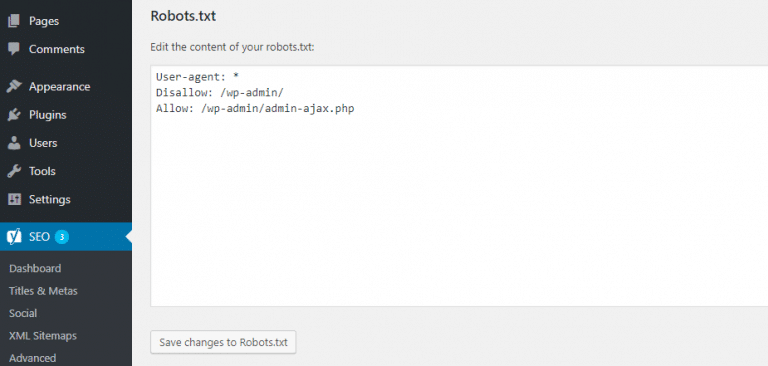

در این مرحله باکسی برای شما نمایش داده می شود که محتوای فایل Robots.txt را می توانید در آن کپی کنید و سپس روی گزینه Save changes to Robots.txt کلیک کنید. در صورتی که فایل Robots.txt قبلاً ایجاد شده باشد، محتوای آن نمایش داده شده و می توانید آن را ویرایش نمایید.

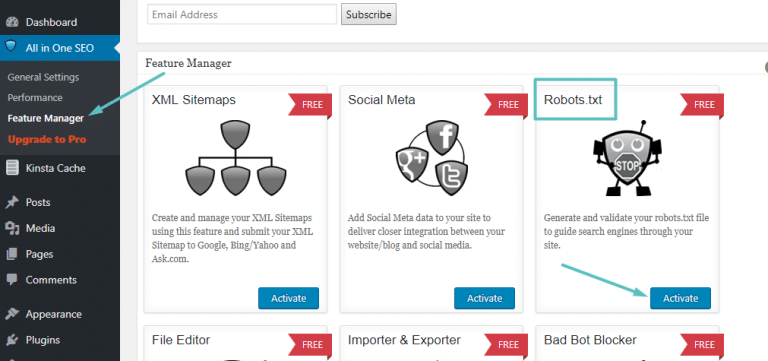

ایجاد و ویرایش فایل Robots.txt با افزونه One SEO

در صورتی که از افزونه One SEO استفاده می کنید، می توانید از آن برای ایجاد و ویرایش فایل Robots.txt برای وبسایت خود استفاده کنید. برای این منظور به مسیرAll in One SEO → Feature Manager رفته و ویژگی Robots.txt را با کلیک روی گزینه Activate، فعال سازی کنید.

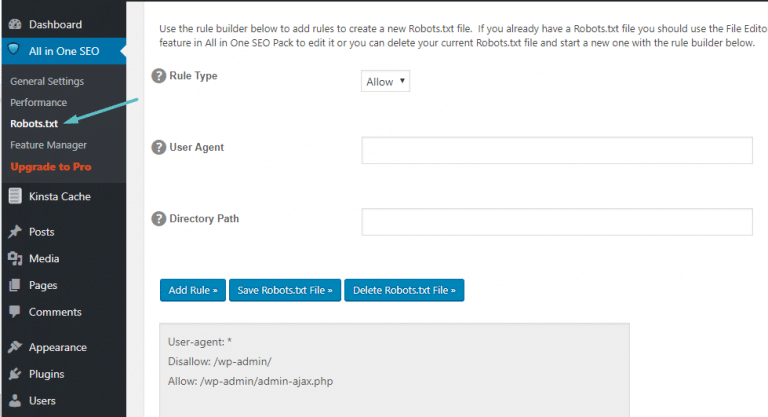

سپس، می توانید فایل Robots.txt را با رفتن به مسیر All in One SEO → Robots.txt: ، مدیریت کنید.

در این صفحه، فیلدهایی برای ورود اطلاعات فراهم شده است. از قسمت Rule Type، نوع دستورالعمل را انتخاب کنید. در فیلد مقابل User Agent، موتور جستجوی مورد نظر را وارد کرده و در فیلد مقابل Directory Path نیز آدرس صفحه ای که می خواهید دستورالعمل برای آن اعمال شود، وارد کنید. پس از این، با کلیک روی گزینه Add Rule، دستورالعمل مربوطه در باکس پایین صفحه نمایش داده می شود. می توانید با کلیک روی گزینه Save Robots.txt File، فایل Robots.txt ایجاد شده را ذخیره نمایید.

روش دیگری نیز برای ایجاد و ویرایش فایل Robots.txt برای سایت وردپرس بدون استفاده از افزونه ها وجود دارد که در واقع روش دستی است. برای این منظور، می توان از FTP استفاده کرد. FTP مخفف کلمه لاتین File transfer protocol به معنی پروتکل انتقال فایل است که برای آپلود و انتقال فایل ها در وردپرس به صورت دستی به کار می رود. برای استفاده از این ویژگی در وردپرس، ابتدا باید نرم افزار FTP client را بر روی کامپیوتر خود نصب کنید. این نرم افزار برای ایجاد ارتباط بین کامپیوتر و وبسایت شما و انتقال فایل ها بر اساس پروتکل FTP به کار می رود. برخی از متداول ترین نرم افزار های FTP client عبارت اند از:

- FileZilla (برای ویندوز، Mac، لینوکس – رایگان)

- WinSCP (برای ویندوز – رایگان)

- Cyberduck (برای Mac – رایگان)

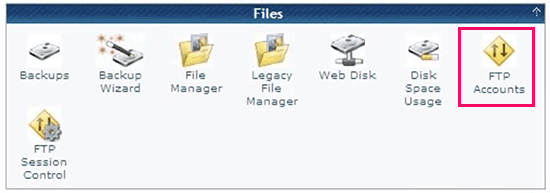

پس از نصب نرم افزار FTP و اجرای آن، از شما خواسته می شود که با استفاده از اطلاعات لاگین FTP، به وبسایت خود متصل شوید. اطلاعات لاگین در داشبود سی پنل حساب کاربری هاست موجود است.

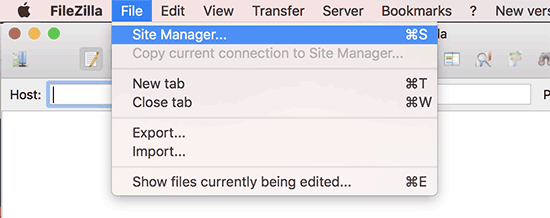

در اینجا، نحوه استفاده از نرم افزار FileZilla را توضیح می دهیم. در صورتی که اطلاعات لاگین را در اختیار دارید، FileZilla را اجرا کرده و به مسیر File » Site Manager بروید.

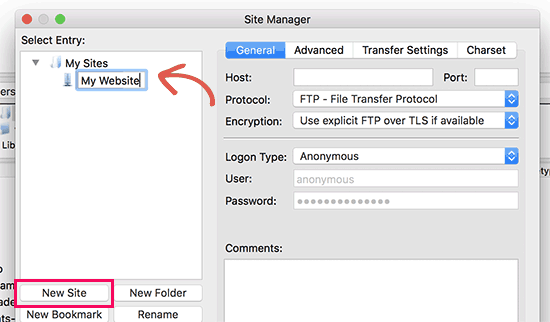

با این کار، یک پنجره pop-up باز می شود که از شما می خواهد اطلاعات وبسایت خود را در آن وارد کنید. روی گزینه New Site کلیک کرده و یک عنوان برای سایت خود بسازید.

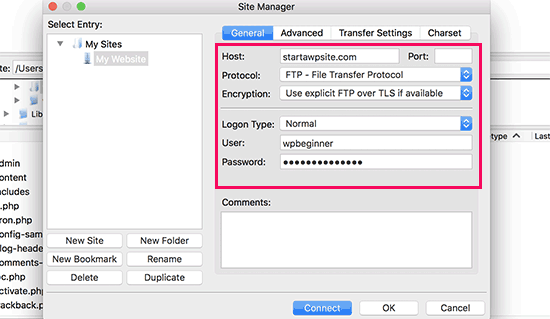

در ستون بعدی، هاست خود را وارد کنید. معمولاً نام هاست همان نام دامنه است. سپس در بخش Protocol، پروتکل FTP را انتخاب کنید. در فیلد Logon Type، حالت Normal را انتخاب کرده و سپس نام کاربری و پسورد FTP را وارد کنید.

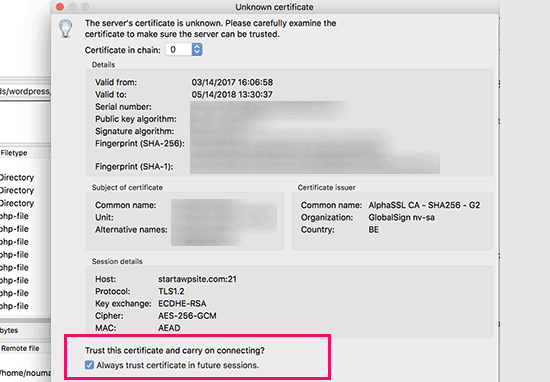

حالا روی دکمه Connect کلید کنید. FileZilla تنظیمات مربوط به وبسایت شما را برای مراجعات بعدی، ذخیره کرده و با وبسایت شما ارتباط می گیرد. اگر برای بار اول از یک کامپیوتر به وبسایت مورد نظر متصل می شوید، پنجره pop-up زیر نمایش داده می شود:

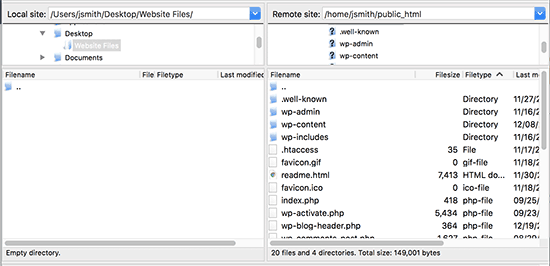

تیک Always trust certificate for future sessions را فعال کرده و روی دکلمه continue کلیک کنید. سپس FileZilla با سایت شما ارتباط می گیرد. پس از اتصال، لیستی از فایل ها و فولدرهای وبسایت شما زیر ستون Remote site نمایش داده می شود.

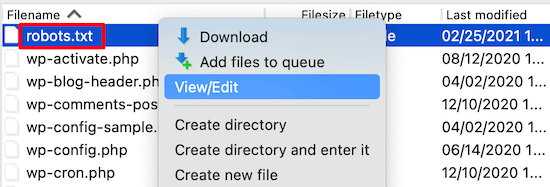

فایل robots.txt را در این ستون پیدا کرده و روی آن کلیک راست کنید، سپس گزینه View/Edit را انتخاب کنید.

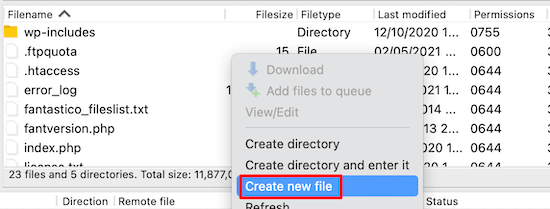

در صورتی که فایل نمایش داده نشد، به این معنی است که قبلاً فایل Robots.txt را ایجاد نکرده اید؛ برای ایجاد یک فایل جدید، در ستونRemote site کلیک راست کرده و گزینه Create new file را انتخاب کنید.

اما در صورتی که فایل Robots.txt موجود باشد، با انتخاب گزینه View/Edit، فایل توسط ادیتورهای متن نظیر Notepad یا TextEdit در کامپیوتر شما باز شده و قابل ویرایش است. پس از ویرایش فایل Robots.txt و ذخیره مجدد آن، می توانید از ستون Local site در FileZilla، آن را آپلود کنید.

نتیجه گیری

فایل Robots.txt یک فایل متنی مهم است که به کمک آن می توانید عملکرد موتورهای جستجو را در بازدید و ایندکس صفحات وبسایت خود، مدیریت کنید. اگر فایل Robots.txt به صورت صحیح ساخته شود، نه تنها باعث بهبود سئوی سایت شده، بلکه به بازدید کننده های سایت شما نیز کمک خواهد کرد.

ایجاد فایل Robots.txt زمان زیادی نمی برد و با یک بار ساخت و آپلود آن، می توانید بعداً محتوای فایل را بر اساس نیاز خود، ویرایش کنید. بنابراین اگر تا کنون این فایل را ایجاد نکرده اید، توصیه می کنیم هرچه زودتر این کار را انجام داده و تنظیمات لازم را در آن انجام دهید. اگر به دنبال بهینه سازی این فایل برای وردپرس هستید پیشنهاد می شود مقاله آموزش بهینه سازی فایل Robots.txt وردپرس برای بهبود سئو را مطالعه نمایید.

دیدگاهتان را بنویسید

برای نوشتن دیدگاه باید وارد بشوید.